高扩展性

根据人工智能工作负载的规模和复杂程度即时扩展计算资源。这在处理波动的数据量时尤其有益。

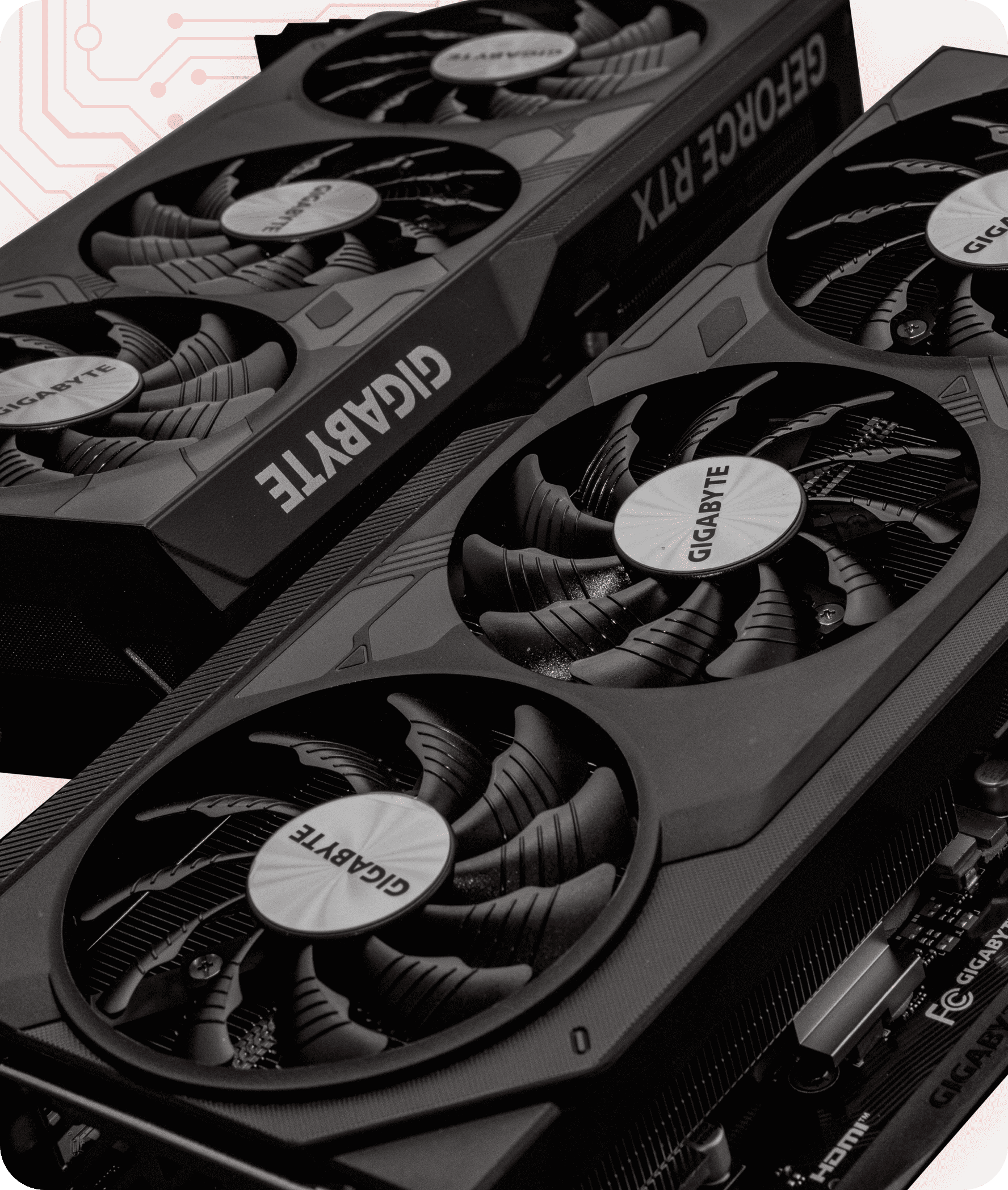

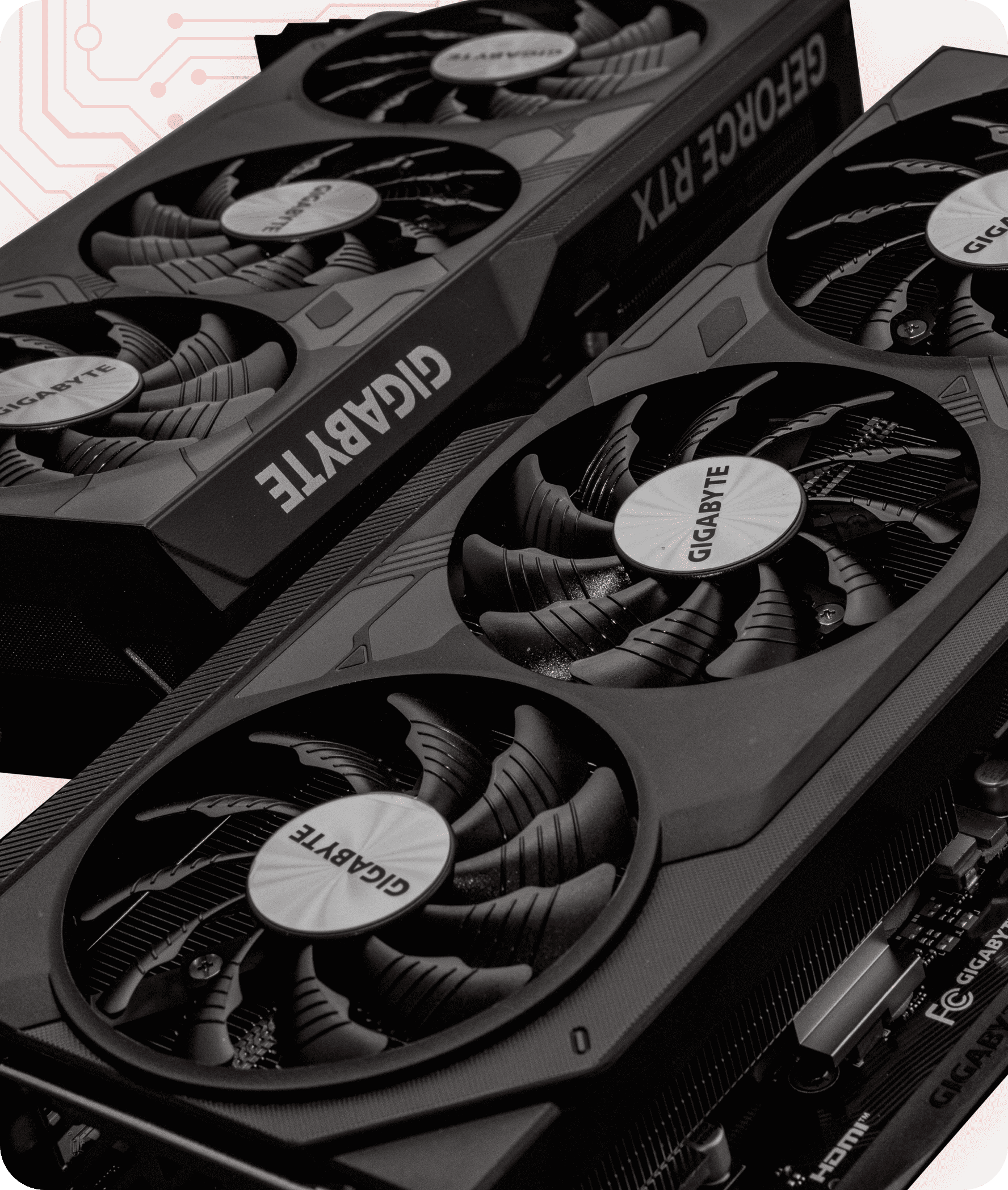

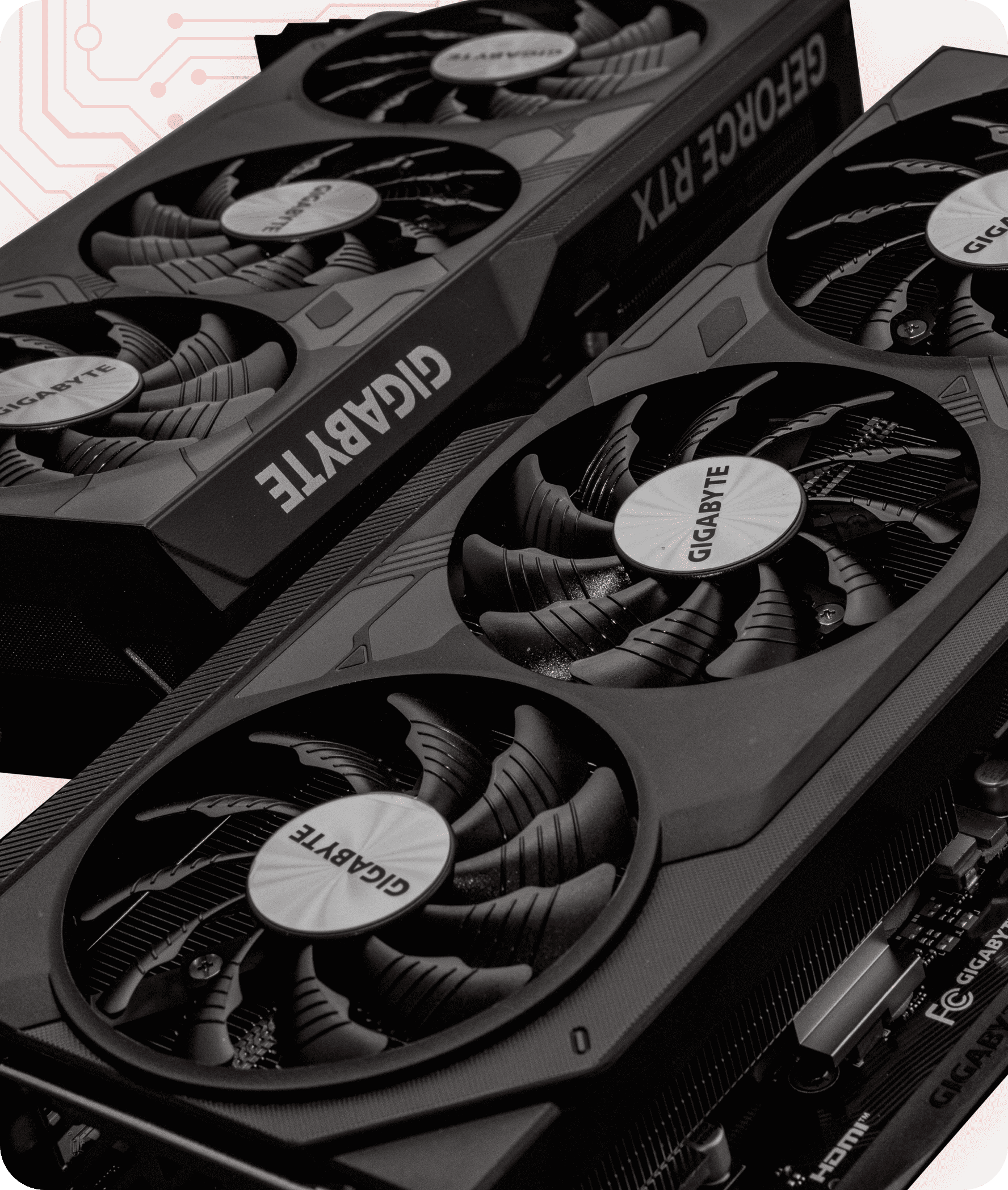

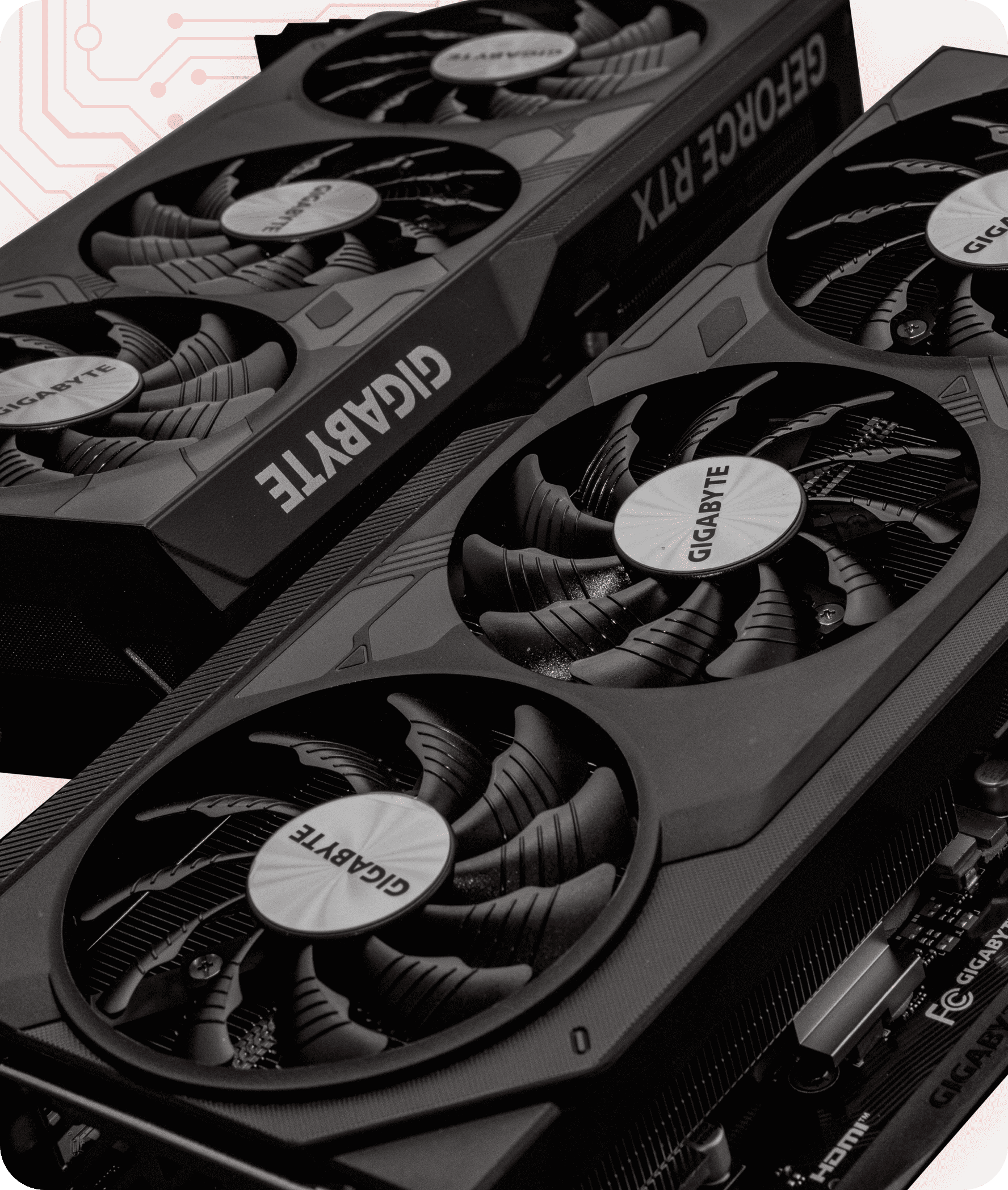

High-performance RTX 4070 Ti SUPER & NVIDIA GeForce RTX 5080 Ti

Flexible Payments

Multi-core CPUs

Faster training for large language models (LLMs)

OS: Ubuntu 22.04 + LLM

OS: Ubuntu 22.04 + LLM

OS: Ubuntu 22.04 + LLM

OS: Ubuntu 22.04 + LLM

OS: Ubuntu 22.04 + LLM

OS: Ubuntu 22.04 + LLM

OS: Ubuntu 22.04 + LLM

OS: Ubuntu 22.04 + LLM

With thousands of processing cores, the GPU powered by dual 4070 Ti and GeForce RTX 5080 Ti matrix operations and calculations in parallel. This significantly accelerates AI training tasks compared to traditional CPUs.

GPUs efficiently manage the intense computational requirements of deep neural networks and recurrent neural networks, which are essential for developing sophisticated deep learning models, including generative AI.

Superior GPU performance, particularly with the dual 4070 Ti’s 16GB GDDR6X memory and 7,680 CUDA cores, and and GeForce RTX 5080 Ticores, is ideal for compute-intensive workloads, including dynamic programming algorithms, video rendering, and scientific simulations.

GPUs offer high memory bandwidth and efficient data transfer capabilities, enhancing the processing and manipulation of large datasets for faster analysis. The 4070 Ti’s and and GeForce RTX 5080 Ti 21 Gbps memory speed and advanced architecture reduce data bottlenecks, accelerating workloads.

Oobabooga Text Gen UI

Oobabooga Text Gen UI PyTorch (CUDA 12.4 + cuDNN)

PyTorch (CUDA 12.4 + cuDNN) SD Webui A1111

SD Webui A1111 Ubuntu 22.04 VM

Ubuntu 22.04 VM Also: At the request, we can install any OS

Also: At the request, we can install any OS

人工智能托管:释放人工智能项目的全部潜能

随着人工智能技术的快速发展,对 AlexHost 人工智能托管解决方案的需求也呈指数级增长。无论您是在开发机器学习模型、训练神经网络,还是在部署高级人工智能应用程序,您所使用的基础设施都对项目的成功起着至关重要的作用。人工智能托管提供了实时支持数据密集型人工智能工作负载所需的性能、可扩展性和灵活性。在本文中,我们将探讨人工智能托管的工作原理、其重要性以及如何根据您的需求选择合适的提供商。

人工智能托管的核心是需要巨大的计算能力。用于人工智能的 GPU 服务器专门用于加速处理那些对传统 CPU 而言过于密集的任务。这些服务器配备高性能图形处理单元,可以处理并行处理,是深度学习、自然语言处理和计算机视觉任务的理想选择。

由 GPU 驱动的环境可显著缩短训练大规模人工智能模型所需的时间。利用专用 GPU 服务器,数据科学家和工程师可以更快地迭代、更高效地优化算法,并获得更高的模型准确性,同时减少操作瓶颈。

人工智能托管服务为企业和开发智能系统的开发人员提供了多项战略优势

根据人工智能工作负载的规模和复杂程度即时扩展计算资源。这在处理波动的数据量时尤其有益。

用多少付多少。AlexHost 提供灵活的计费方式,包括按小时或按使用量计费。

可使用高端 GPU(如i9-7900x(x10) 和Ryzen™ 9 3950X(x16))、NVMe SSD存储和大容量内存,这些对于高效模型训练和推理至关重要。

我们在摩尔多瓦的数据中心是一个很好的选择,可以最大限度地减少延迟,确保不同地区的高可用性。

利用企业级安全协议和合规认证保护敏感的人工智能数据

由 GPU 驱动的环境可显著缩短训练大规模人工智能模型所需的时间。利用专用 GPU 服务器,数据科学家和工程师可以更快地迭代、更高效地优化算法,并获得更高的模型准确性,同时减少操作瓶颈。

在选择人工智能 GPU 服务器托管时,评估提供商的硬件规格、支持选项、网络基础设施和定价模式至关重要。寻找包含以下功能的服务器

最新英伟达(2x RTX 4070 Ti SUPER)或 AMD GPU 架构(如 Ryzen™ 9 3950X 和 i9-7900x)

专用资源(没有吵闹的邻居)

高带宽网络(至少 1 Gbps)

支持 TensorFlow、PyTorch 和 JAX 等主要人工智能框架

可选裸机或虚拟化环境

此外,AlexHost 还提供预配置的人工智能环境,使用户更容易上手,无需冗长的设置时间。

使用 AlexHost 进行人工智能托管可用于多种

用例,包括但不限于:

为文本生成、翻译、情感分析和聊天机器人训练模型 。

开发 面部识别系统、医学图像诊断或视频分析。

分析历史数据,预测趋势、客户行为或维护计划。

根据训练数据构建可生成图像、音乐、代码或文本的应用程序。

为机器人、游戏和自主代理模拟环境 。